Tu vuo far el phdino

HERITRACE

- Quando viene cancellata una proprietà virtuale, viene in realtà cancellata l’entità attraverso la quale è stata implementata quella proprietà virtuale.

- Le proprietà virtuali ovviamente non compaiono nel change tracking dell’entità. Per ora va bene così.

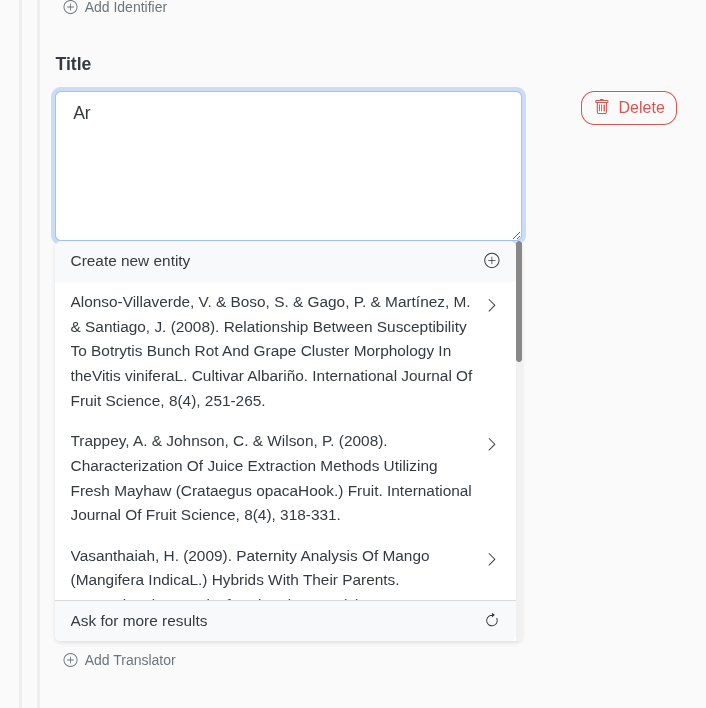

- La ricerca delle entità esistenti ora mostra un menu a tendina in cui ogni elemento è multilinea in maniera tale che il nome dell’elemento sia interamente visibile.

- Risolto il bug per cui venivano catturati i click programmatici per espandere le proprietà obbligatorie e questi chiudevano il menu a tendina per la ricerca delle entità preesistenti.

1

2

3

4

5

6

7

8

9

10

11$(document).on('click', function(e) {

// Ignora i click programmatici (non generati dall'utente)

if (!e.isTrusted) {

return;

}

if (!$(e.target).closest('.newEntityPropertyContainer').length) {

$('.entity-search-results').addClass('d-none');

$('.search-spinner').addClass('d-none');

}

}); - Non avevo ancora gestito il caso in cui sh:hasvalue è un elenco di URI e non un elenco di nodi, ovvero di shape o di datatype e in particolare non avevo gestito la generazione del form di modifica per questo tipo di casistica in cui deve essere mostrato un select option e non un input type text.

- introdurre la possibilità di selezionare il tipo di risorsa bibliografica citata ha reintrodotto il problema di performance lato frontend che pure era stato parzialmente risolto caricando in maniera asincrona soltanto i modelli per l’edità selezionata. Ho scelto di affrontare questo nuovo problema in maniera ibrida, continuando a caricare in maniera asincrona soltanto il modello dell’entità selezionata ma non delle entità annidate oltre il livello di profondità 1, che vengono caricate in maniera asincrona anch’esse.

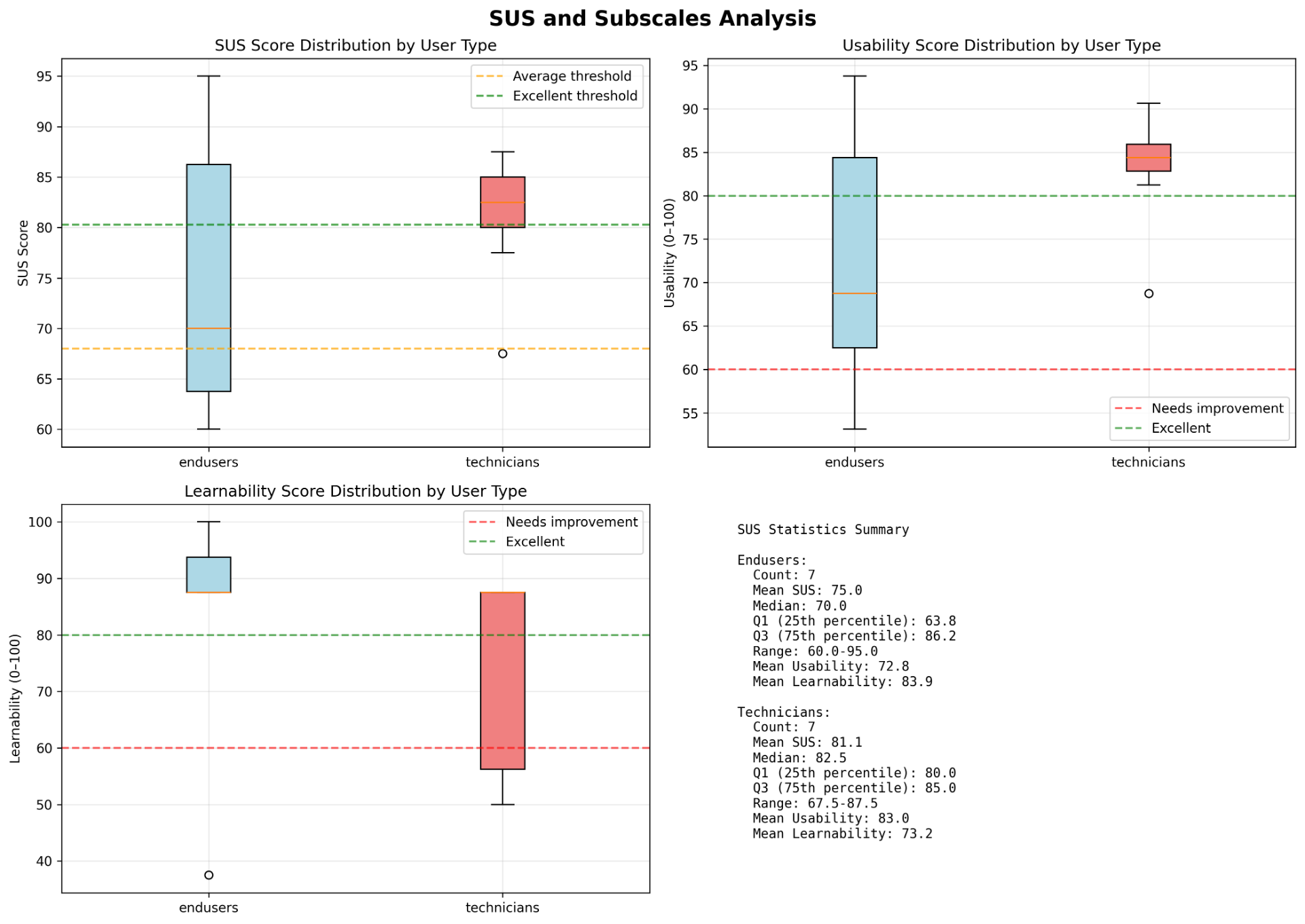

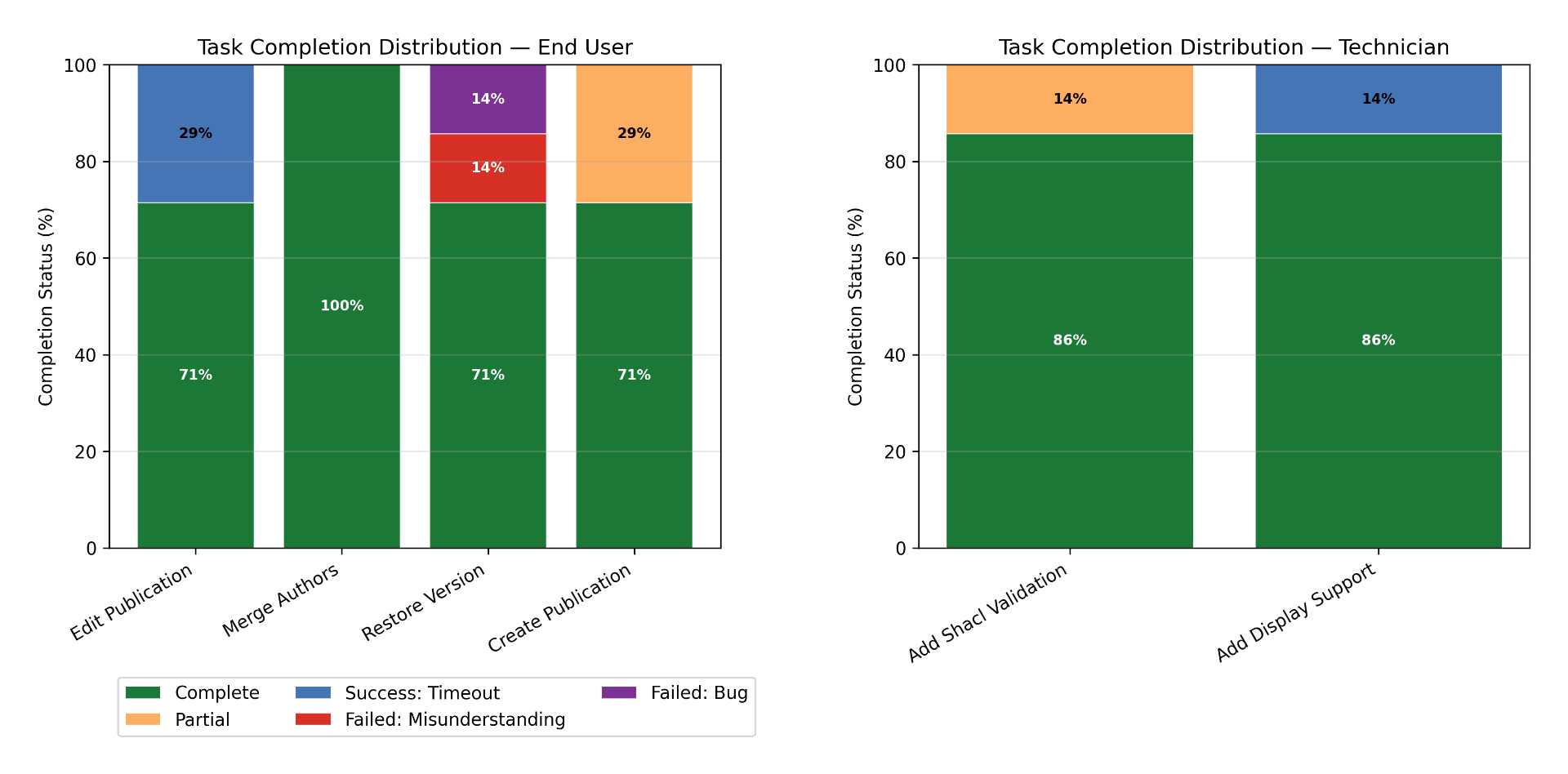

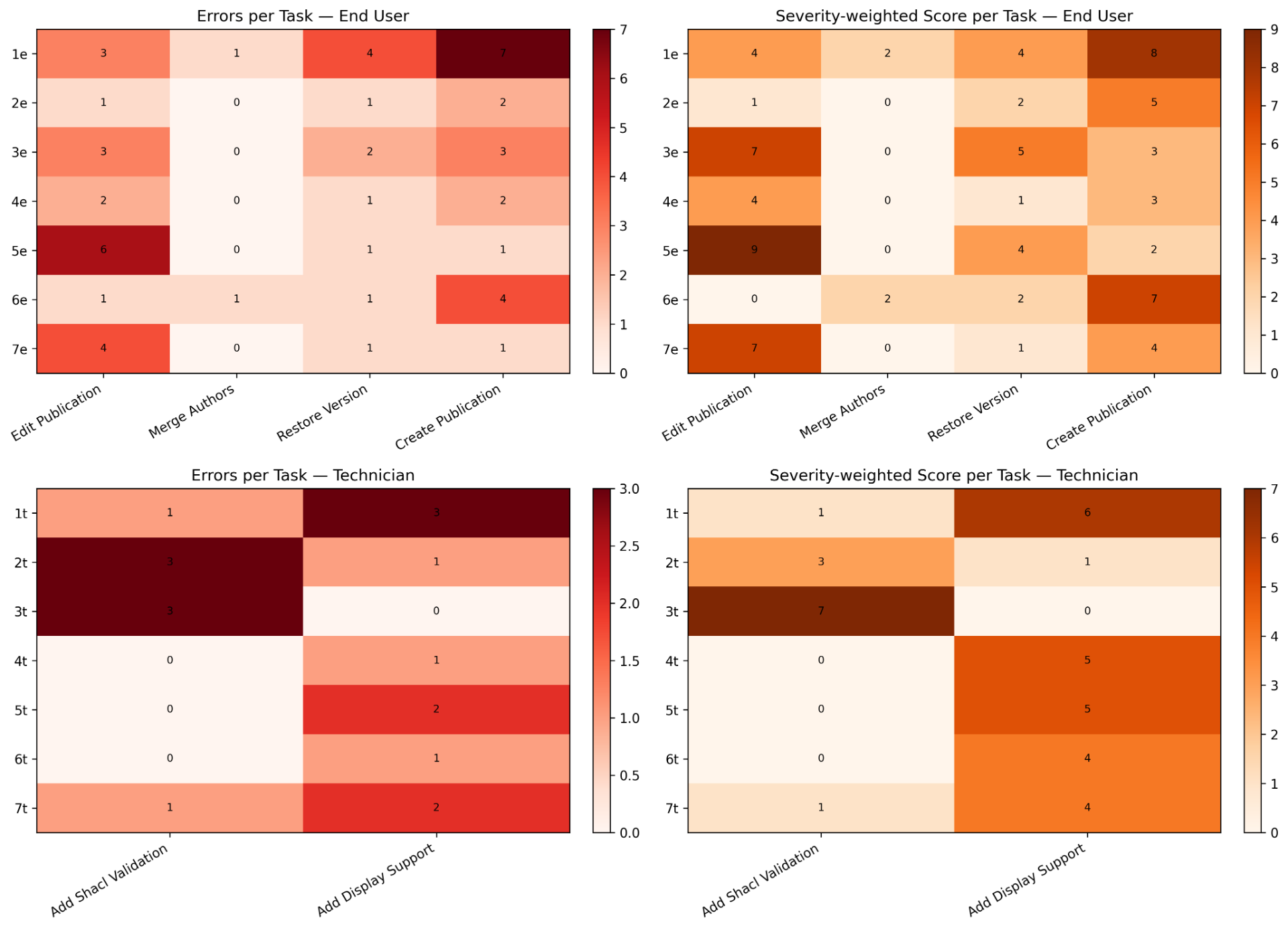

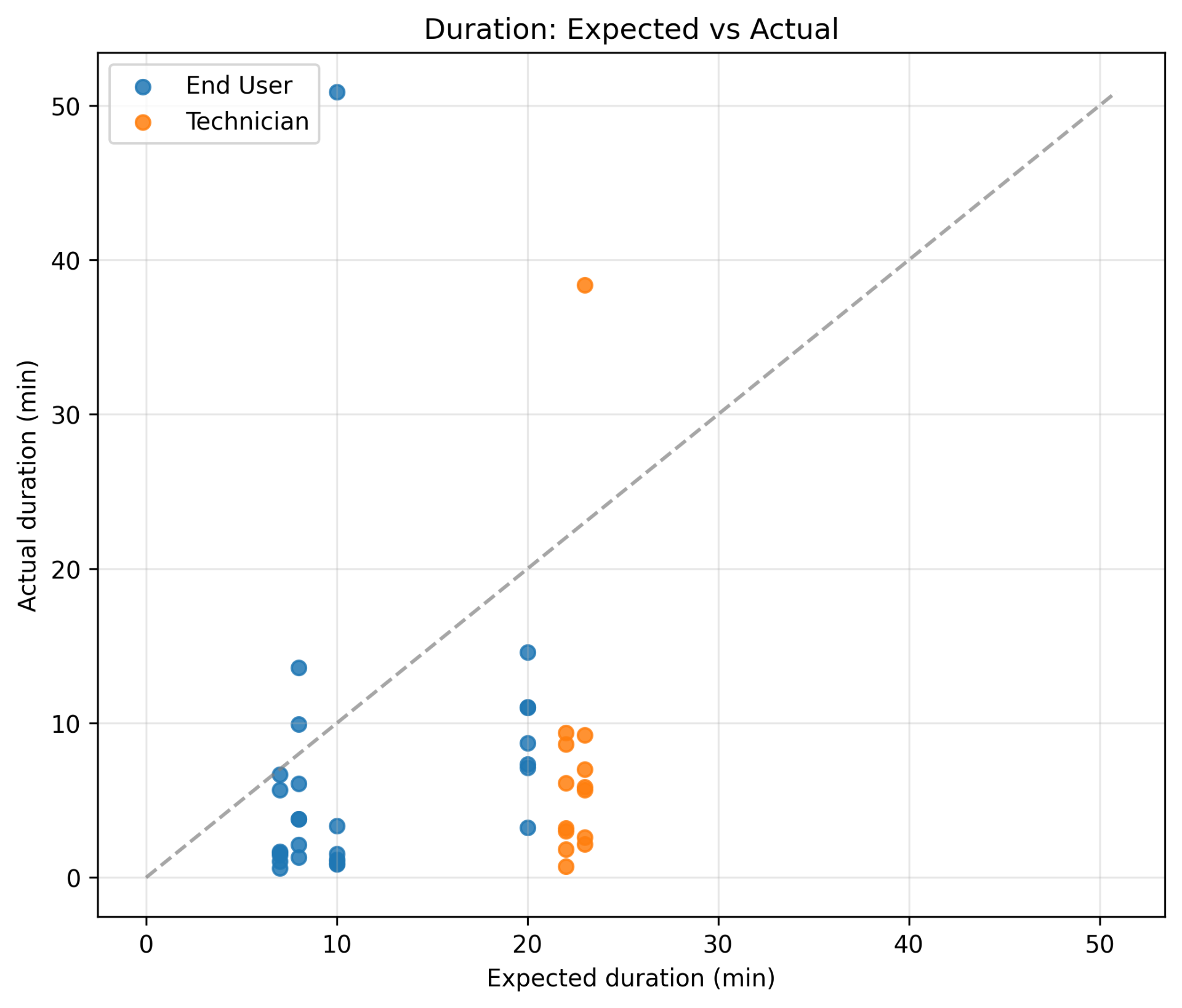

User testing

- Uno dei tester mi ha segnalato che la porta 5000 è di default occupata nelle ultime versioni di macOS da AirPlay, quindi ho modificato l’ambiente per esporre la 5001.

Bugfix

- Mi ero dimenticato di aggiornare anche l’inizializzatore dei contatori per tenere conto dei nuovi URI delle citazioni e ora l’ho fatto.

Crash course su Git

OC Meta

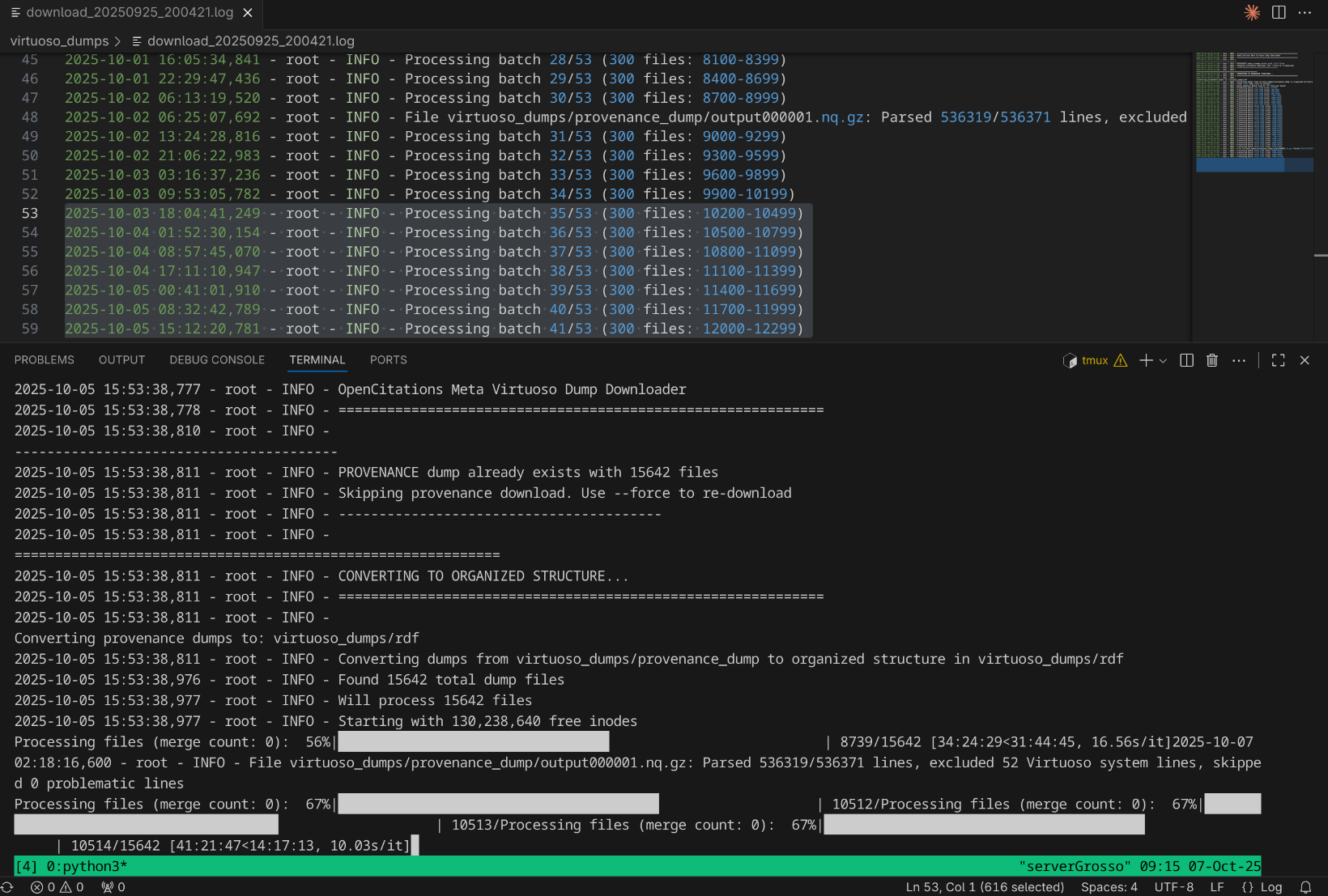

- Il sistema di conversione del dump in RDF da Virtuoso alla struttura di cartelle e sottocartelle di OpenCentations Meta è fallito a 40 su 53 batch per la provenance dopo 10 giorni di processing.

- Questo mi ha dato l’occasione per ripensare il sistema e renderlo più efficiente. Anziché fare merge dei file temporanei dopo batch artificiali, ad esempio ogni 300 file, che richiede ogni volta 3 ore per fare il merge esplorando milioni di file, anche se in parallelo, adesso il merge viene triggerato soltanto quando mancano meno di 10 milioni di inode disponibili.

- Già che c’ero ho aggiunto un sistema di caching per cui processato un file del dump di virtuoso correttamente e viene salvato su un file in maniera tale da non essere più riprocessato.

Domande

- 20 ottobre

Memo

HERITRACE

- C’è un bug che si verifica quando uno seleziona un’entità preesistente, poi clicca sulla X e inserisce i metadati a mano. Alcuni metadati vengono duplicati.

- Se uno ripristina una sotto entità a seguito di un merge, l’entità principale potrebbe rompersi.

Tesi

- Aggiungere ParaText

- RML

- Crowdsourcing future works

- Descrivere l’architettura di HERITRACE

OpenCitations

- Rifare dump (Crossref e Datacite)

- Risolvere la questione ORCID

- Rilanciare processo eliminazione duplicati

“reference”: { “@id”: “frbr:part”, “@type”: “@vocab” } → bibreference

“crossref”: { “@id”: “biro:references”, “@type”: “@vocab”} → reference

“crossref”: “datacite:crossref”

Ripubblicare dbpedia agnostica su Zenodo e si può usare time-agnostic-library su db pedia agnostica

oc_ocdm

- Automatizzare mark_as_restored di default. è possibile disabilitare e fare a mano mark_as_restored.

https://opencitations.net/meta/api/v1/metadata/doi:10.1093/acprof:oso/9780199977628.001.0001

Guida per Meta e cerotti

DELETE con variabile

Modificare Meta sulla base della tabella di Elia

embodiment multipli devono essere purgati a monte

Portare il Meta Editor fuori. oc_editor

Modificare documentazione API aggiungendo omid

Heritrace

- Per risolvere le performance del time-vault non usare la time-agnostic-library, ma guarda solo la query di update dello snapshot di cancellazione.

- Ordine dato all’indice dell’elemento

- date: formato

- anni: essere meno stretto sugli anni. Problema ISO per 999. 0999?

- Opzione per evitare counting

- Opzione per non aggiungere la lista delle risorse, che posso comunque essere cercate

- Configurabilità troppa fatica

- Collegamento da review e articolo revisionato.

- Timer massimo. Timer configurabile. Messaggio in caso si stia per toccare il timer massimo.

- Riflettere su @lang. SKOS come use case. skos:prefLabel, skos:altLabel

- Possibilità di specificare l’URI a mano in fase di creazione

- la base è non specificare la sorgente, perché non sarà mai quella iniziale.

- desvription con l’entità e stata modificata. Tipo commit

- display name è References Cited by VA bene

- Avvertire l’utente del disastro imminente nel caso in cui provi a cancellare un volume

Meta

- Fusione: chi ha più metadati compilati. A parità di metadato si tiene l’omid più basso

- Issue github parallelizzazione virtuoso

- frbr:partOf non deve aggiungere nel merge: https://opencitations.net/meta/api/v1/metadata/omid:br/06304322094

- API v2

- Usare il triplestore di provenance per fare 303 in caso di entità mergiate o mostrare la provenance in caso di cancellazione e basta.

RML

- Vedere come morh kgc rappresenta database internamente

- https://dylanvanassche.be/assets/pdf/iswc2024-krown-benchmark-rdf-graph-materialisation.pdf

https://github.com/oeg-upm/gtfs-bench

- Chiedere Ionannisil diagramma che ha usato per auto rml.

Crowdsourcing

- Quando dobbiamo ingerire Crossref stoppo manualmente OJS. Si mette una nota nel repository per dire le cose. Ogni mese.

- Aggiornamenti al dump incrementali. Si usa un nuovo prefisso e si aggiungono dati solo a quel CSV.

- Bisogna usare il DOI di Zenodo come primary source. Un unico DOI per batch process.

- Bisogna fare l’aggiornamento sulla copia e poi bisogna automatizzare lo switch

docker compose atom melody, con un volume per gli asset. C’è una documentazione su come si lanciano entrambi fatti da Giulia Renda. Fine maggio

Archivio

10-02-2022. Triplestore del terzo tipo

16-03-2022. Opinionated Meta model

22-03-2022. GraphDB vs Blazegraph

29-03-2022. Pattern per volumi e numeri

08-04-2022. Time-agnostic-library +300%

19-04-2022. 1 task per process and lock on files

13-05-2022. Time-agnostic-library ultra-compatibile

17-05-2022. Codice benchmark tab aggiornato

26-05-2022. Progetto di dottorato v1.0.0

07-06-2022. In preparazione alla lettera di risposta

21-06-2022. It’s outreach time

19-07-2022. I wish my code will work at the first time

06-09-2022. Query combinate con le apette

13-09-2022. OpenCitations full automations

20-09-2022. OpenCitations full automated

13-10-2022. Anche Crossref rompe i DOI

20-10-2022. OpenAIRE Research Graph

25-10-2022. OpenCitations Meta

03-11-2022. Fuso orario nella provenance

08-11-2022. Ottimizzazione API OC Meta

22-11-2022. Programmazione agile

01-12-2022. L’articolo su Meta è pronto

20-12-2022. Il giorno del lancio

17-01-2023. Inizio del dottorato

31-01-2023. merge tra entità con prefissi diversi

07-02-2023. rdflib-ocdm genera gli snapshot

07-03-2023. oc_ocdm usa SHACLE

17-04-2023. SPARQLWrapper timeout

27-04-2023. Conversione BEAR fatta

02-05-2023. Meta: 28 min → 3 min

09-05-2023. Bug autori API risolto

16-05-2023. Pseudocodice in LaTeX

23-05-2023. Pseudocodice come?

25-07-2023. Una-Her-Doc bureaucracy

12-09-2023. Mi è scappata la mano e ho finito il dottorato

26-09-2023. Articolo Meta fatto

22-11-2023. Risolto il bug dei bug in Meta

11-01-2023. ExportKB dà problemi

18-12-2023. Merge delle entità duplicate

23-01-2024. Programmazione tutoraggio

01-02-2023. Primo lancio dei test su BEAR

07-02-2024. time-agnostic-library da ripensare

12-03-2024. Align data with triplestore

19-03-2024. supplier_prefix once again

26-03-2024. Ricorsione SPARQL manuale

17-04-2024. Il lusso della qualità

23-04-2024. Ho sfasciato il PC

20-05-2024. Primo tentativo di resuscitazione fallito

30-05-2024. Migrazione su Virtuoso

04-06-2024. Esoterismo virtuoso

11-06-2024. Migrazione riuscita

25-06-2024. R2RML tests completed

30-07-2024. Finalmente ho trovato i bug in Meta

09-11-2024. Tre entità alla volta

18-09-2024. HERITRACE: issue, volume, journal

27-09-2024. SHACL Advanced Features

01-10-2024. Contatori su Redis

08-10-2024. Nuove proprietà di entità esistenti

31-10-2024. Correzione della provenance

07-11-2024. Ricerca su HERITRACE

11-11-2024. HERITACE è più bellino

02-12-2024. Meta: disaster recovery

09-12-2024. HERITRACE: lock risorse

30-01-2025. Bug storici di Meta risolti

04-02-2025. Archiviazione automatica report validazione

23-02-2025. Revisione provenance DSH

27-02-2025. HERITRACE Francesca buggifixxi

25-03-2025. Top level search in nested search

02-04-2025. Script provenance Aldrovandi

16-04-2025. Interfaccia di merge

24-04-2025. Time Agnostic Mess

08-05-2025. Bulk load della provenance fatto

05-06-2025. Meta fulmine di guerra ed HERITRACE 1.0.0 terminata

10-06-2025. Merge CSV dumps light

24-06-2025. Test di usabilità su HERITRACE